人工智慧時代計算架構的結構性演進:CPU、GPU與TPU - 您需要哪個U?

在一個繁忙的數位廚房裡,晚餐服務即將開始。

中心站著主廚CPU,這位沉著而經驗豐富的大廚。雖然只有幾把刀,但憑藉多年的訓練,CPU負責閱讀訂單、規劃菜單,並告訴每個人下一步該做什麼。時機掌握、協調指揮和精確執行是CPU的專長。沒有這位主廚,廚房將陷入混亂。

幕後,隨著GPU製作團隊開始行動,氣氛變得火熱。數百名廚師以完美的節奏協同工作,揉麵、油炸、堆疊,成千上萬的源源不絕的食物。每個廚師只負責一小項任務,但在一起,他們就能以驚人的速度生產出源源不絕的金黃色食物。每當有大型宴會——或者說AI模型訓練——需要完成時,這個團隊就承擔起了主要工作量。

接著,在一個安靜的角落,TPU甜點機器人嗡嗡啟動。它不關心菜單或種類。它唯一的工作就是一遍又一遍地炸出完美的螺旋狀甜點,幾乎不浪費油或能源。對於這項任務,廚房裡沒有誰能比它更有效率。當訂單量龐大且可預測時,這台機器人永遠不會減速。

隨著夜晚的進行,廚房的秘密變得清晰:主廚不與GPU團隊競爭,GPU團隊也不怕機器人。三者各司其職。它們一起,快速、有效率、不知疲倦地服務數百萬份餐盤。這就是現代AI廚房的運作方式:

CPU規劃,GPU擴展,TPU最佳化。

人工智慧:計算領域的結構性力量

人工智慧已超越漸進式軟體創新的範疇,演變為重塑全球計算產業的結構性力量。與以往的技術週期(如企業軟體、行動計算或早期雲端服務)不同,現代AI的進步日益受到物理和經濟極限的制約,而不僅僅是演算法創造力的推動。深度學習模型,特別是大語言模型和多模態系統的爆炸式增長,驅動了對計算能力、記憶體頻寬和電力的空前需求。

因此,傳統的、以CPU為中心的同構計算範式已不再適用。相反,行業正在經歷一場向異構計算架構的結構性轉型,這種架構結合了CPU、GPU以及諸如張量處理器等專用加速器。這種轉型並非短期優化,而是對物理、能源可用性和規模經濟所施加的根本性約束的持久需求。對投資者而言,理解這些架構如何不同、將如何演變、以及為何可能長期共存,對於將AI基礎設施作為一個長期投資主題進行評估至關重要。

同構計算的局限與異構化的崛起

在過去的近四十年裡,計算性能的提升主要通過一個相對簡單的機制實現:更快的CPU支援了更複雜的軟體。半導體製造的進步,結合指令級平行和推測執行等架構技術,使得通用處理器能夠提供穩定的性能增益。然而,這種方法已接近收益遞減的臨界點。

AI工作負載加速暴露了這些極限。深度學習極度依賴密集的數值計算,尤其是反覆應用於大型資料集的矩陣乘法。這些工作負載表現出高算術強度但分支極少,使其極不適合為控制密集型、不規則執行模式優化的CPU。試圖純粹在CPU上擴展AI會導致硬體利用率低下和不可持續的能耗。

因此,異構計算作為一種結構性需求而非設計偏好應運而生。通過將計算的不同階段分配給為特定約束優化的架構,異構系統極大地提高了整體效率。現代AI系統日益類似精心設計的流水線,而非單一的計算單元,這反映了計算生產與消費方式的根本性轉變。

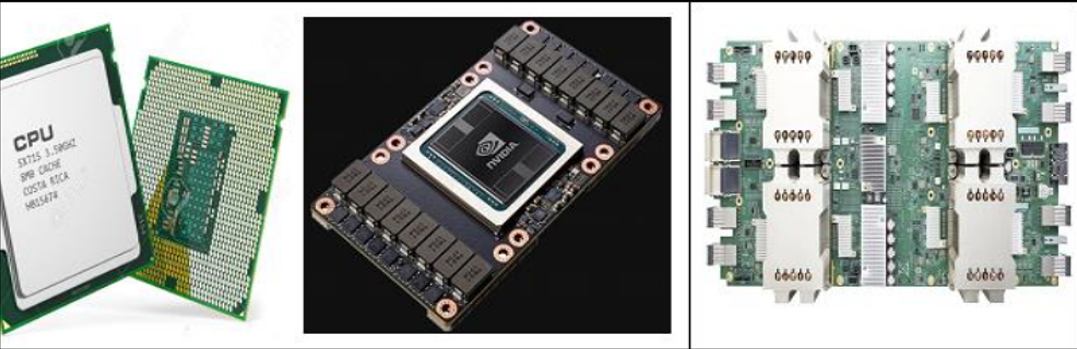

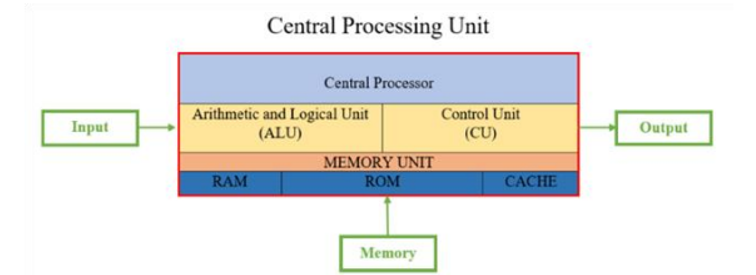

CPU:從主要計算引擎到系統控制平面

儘管CPU在原始AI計算中的作用在下降,但它們仍然是現代系統中不可或缺的組成部分。其架構優勢------靈活性、精確控制和廣泛相容性------使其非常適合執行加速器無法高效完成的系統協調任務。

在異構環境中,CPU負責任務排程、協調加速器間的資料移動、處理輸入/輸出操作,並確保整體系統穩定性。隨著AI工作負載變得更加複雜,這些職責變得更為關鍵而非次要。行業路線圖日益強調CPU在記憶體頻寬、互連技術和一致性互聯架構方面的投資,以實現與GPU和定制加速器更緊密的整合。

展望未來,CPU可能會深化其作為控制平面處理器的角色。其經濟價值將較少來自基準測試的領先,而更多來自平台可靠性、生態系統相容性以及與異構系統的整合。從投資角度看,這表明與CPU相關的業務可能展現出更穩定、低波動的增長特徵,其基礎是即便在AI加速器佔據增量計算支出的情況下,它們在企業與雲基礎設施中的穩固地位。

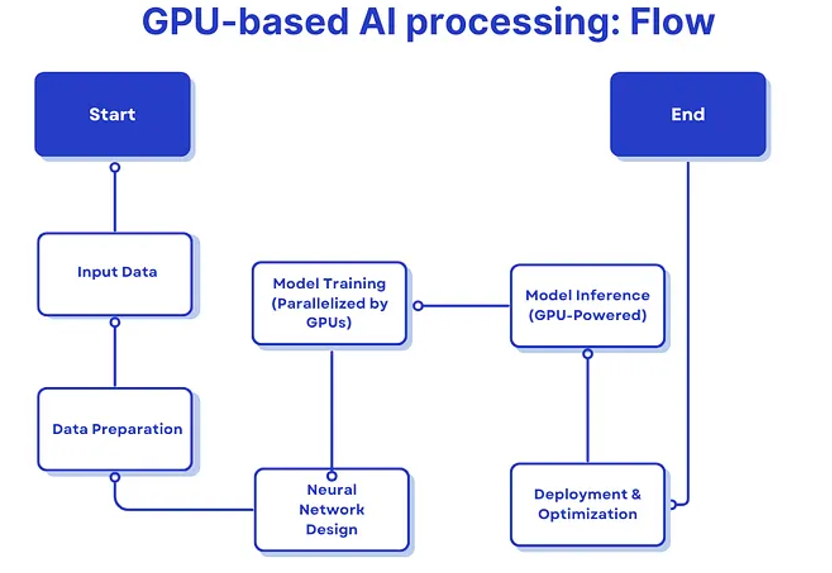

GPU:AI計算基礎設施的支柱

GPU在當今AI計算版圖中佔據核心地位。最初為圖形渲染設計,GPU圍繞大規模平行架構建構,使數千個簡單計算核心能夠同時執行相同操作。這種設計自然契合深度學習工作負載的資料平行結構。

GPU區別於更專用加速器的特點在於其吞吐量與適應性之間的平衡。GPU犧牲了一些控制複雜性,以換取巨大的算術密度,同時保持足夠的可程式設計性以支援不斷發展的演算法、數值格式和訓練技術。這種靈活性得到了成熟軟體生態系統(特別是CUDA和GPU優化的AI框架)的強化,從而創造了強大的網路效應和高昂的轉換成本。

隨著AI模型不斷擴展規模,GPU正在演進以應對新出現的約束。近期的架構趨勢強調低精度算術、高頻寬記憶體、基於小晶片的設計以及日益複雜的互連技術,以支援大型緊密耦合的叢集。這些創新並非旨在最大化峰值性能,而是在日益嚴峻的能耗和通信約束下維持效率和可擴展性。

從投資角度看,GPU代表核心基礎設施資產而非週期性硬體產品。其價值不僅源於性能領先,還來自生態系統主導地位、開發者依賴性,以及其深度整合到雲平台和企業工作流程中的程度。

TPU與定制加速器:超規模的專業化

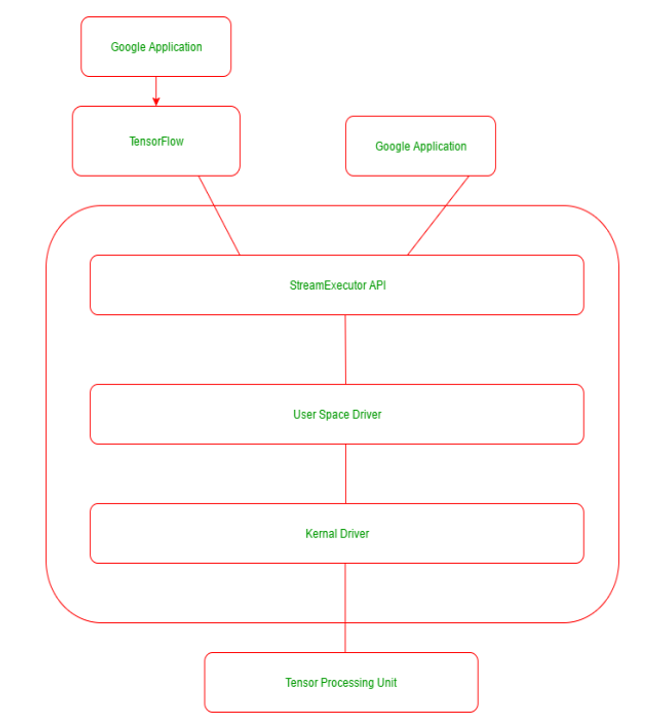

TPU體現了一種更專業化的AI計算方法。明確為張量運算設計,TPU透過諸如脈動陣列和大型片上緩衝區等架構特性優化資料流並最小化記憶體存取。這些設計選擇使得符合TPU假設的工作負載能實現顯著更高的每瓦性能。

TPU的經濟邏輯在超大規模運營中最為強大。大型雲端運營商在嚴格的電力、冷卻和空間約束下運營,即使是微小的效率提升也能轉化為巨大的長期成本節約。定制加速器還允許超大規模運營商減少對第三方硬體的依賴,並針對內部工作負載優化性能。

然而,專業化帶來了剛性。TPU的靈活性不如GPU,並且依賴穩定、可預測的工作負載來證明其開發和部署成本的合理性。因此,其採用集中在少數具備足夠規模和工程資源的超大規模運營商中。對投資者而言,這一趨勢表明AI基礎設施領域的垂直整合和市場集中度將增加,而非廣泛的顛覆。

能源、功耗與AI擴展的經濟學

能源消耗已成為限制AI擴展的主要瓶頸。主要雲端供應商的公開揭露日益凸顯電力可用性和效率是未來產能擴張的限制因素。不斷上漲的電價、電網約束和永續發展壓力都影響著硬體選擇和系統設計。

這一現實有利於最小化資料移動且能在較低數值精度下高效運行的架構。GPU和TPU透過不同的設計理念朝此方向演進,而CPU則在功耗感知排程和系統優化中扮演關鍵角色。未來十年,能效的改善可能比峰值計算性能的提升更為重要。

對投資者而言,這種轉變意味著AI基礎設施的競爭優勢將越來越多地由系統級效率而非孤立的組件指標決定。能夠整體優化功耗、冷卻和利用率的平台,可能會優於僅關注原始性能的平台。

隨著計算效率的提高,瓶頸正在向記憶體頻寬、互連延遲和封裝技術轉移。高頻寬記憶體、先進的小晶片架構以及日益複雜的互連結構正成為AI系統性能的核心。

行業研究一致表明,減少資料移動比單純增加計算密度能帶來更大的效率提升。這一洞見推動了對2.5D和3D封裝、光互連以及近記憶體處理概念的投入。這些發展模糊了計算與系統設計的界限,強化了整合能力的重要性。

從投資角度看,GPU代表核心基礎設施資產而非週期性硬體產品。其價值不僅源於性能領先,還來自生態系統主導地位、開發者依賴性,以及其深度整合到雲平台和企業工作流程中的程度。.

訓練和推理對計算系統提出了根本不同的要求。訓練工作負載具有實驗性、迭代性和動態性,適合GPU等靈活平台。相比之下,推理工作負載優先考慮效率、可預測性和成本最小化。

隨著AI應用到消費級和企業級部署,推理預計將主導總計算消耗。這一轉變對架構需求具有重要影響,提高了針對高能效推理優化的專用加速器的相關性。隨著時間的推移,專注於推理的硬體可能會佔據AI基礎設施支出的越來越大的份額,即使訓練對於創新而言仍具有戰略重要性。

一種架構最終將取代其他架構的觀點,過度簡化了現代計算系統的經濟學。CPU、GPU和TPU針對不同的約束進行優化,因此在計算堆疊中佔據不同的位置。試圖強迫一種架構承擔另一種架構的角色,通常會導致效率低下而非競爭性取代。

相反,行業正趨向於一種異構架構共存的層級化均衡。這種共存反映了在物理、經濟和營運約束下的理性優化,並且隨著AI工作負載的多樣化而非趨同,這種狀態很可能持續下去。

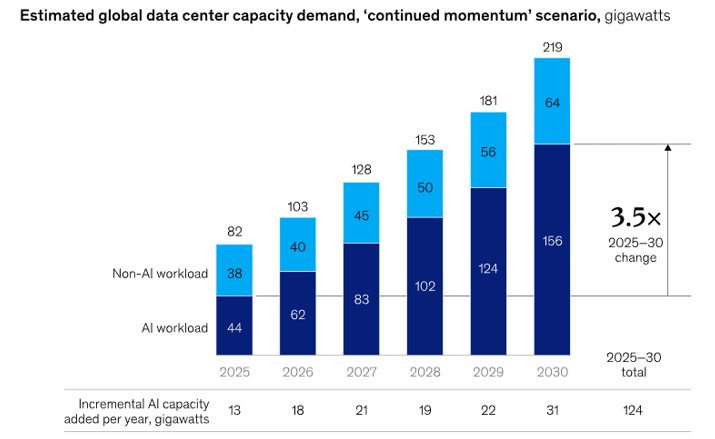

長期投資展望:作為基礎設施的AI計算

從投資角度看,應堅定不移地將AI計算視為一個長達數十年的基礎設施主題,而非週期性的硬體市場,投資機會主要集中於AI堆疊的底層,而非AI應用或大語言模型的所有權。據廣泛估計,到2030年,全球在AI相關計算、資料中心和電力基礎設施上的累計支出將達到1至1.5兆美元,主要由超大規模雲端供應商和構建基礎能力的大型企業驅動。即使在建設高峰期,年度AI基礎設施投資預計也將保持在全球GDP的1%以下,這與之前雲端資料中心和電信網路等基礎設施週期的規模一致。基礎設施層的需求動態本質上是結構性的:雖然演算法和硬體效率每年以估計30-40%的速度提升,但總AI計算消耗量卻以每年60-80%以上的速度增長,造成了持續的供需缺口,必須透過對物理和數位基礎設施的持續投資來解決。

在AI基礎設施領域,價值創造日益分布在相互依賴的底層組件之間,而非應用層級的差異化上。在基礎層,電力供應、電網接入和資料中心房地產正成為關鍵制約因素,AI工作負載每個機架的功耗比傳統雲工作負載高2-5倍。其上是核心計算層,包括用於系統協調的CPU、用於靈活平行計算的GPU,以及為高效推理優化的TPU等定制加速器。隨著模型規模推高通信開銷和利用效率,網路、記憶體和互連技術(包括高速互連架構和先進封裝)變得同樣關鍵。在系統軟體層,排程器、編譯器和基礎設施軟體日益決定利用率和總擁有成本,強化了垂直整合整個底層堆疊的戰略重要性。

推理預計將成為主導的長期需求驅動力,進一步強化了基礎設施的投資邏輯。行業預測一致認為,到本年代末,總AI計算需求的70-80%將來自推理而非訓練。與模型開發或應用採用不同,推理需求是持續的、可重複的,並且與實際使用緊密耦合,這有效地將AI計算、電力和網路轉化為嵌入消費者、企業和公共部門系統中的、類似於公用事業的可重複性成本基礎。這種動態大大降低了對任何單一模型範式的依賴,並支援對底層基礎設施的持久需求,無論最終哪些應用或模型勝出。

在這種格局下,投資結果很可能高度偏向於堆疊底層內的平台級和系統級贏家。持久的價值最有可能流向那些將計算硬體、網路、電力、資料中心資產和系統軟體整合為統一平台的生態系統,使其能夠在規模上實現卓越的利用率、可擴展性和成本效益。相比之下,孤立的組件優勢------無論是在CPU、GPU還是定制加速器方面------如果沒有生態系統鎖定、部署規模和整合深度,就面臨被侵蝕的風險。因此,AI時代計算架構的演進特點是差異化而非趨同:CPU、GPU和TPU不是替代品,而是異構系統中針對不同物理、經濟和營運約束優化的互補組件。這種共存反映了一種結構穩定的均衡,而非過渡階段。

隨著人工智慧持續重塑全球經濟的生產力、勞動力和資本配置,基礎設施層的異構計算架構很可能仍然是支柱性的數位公用基礎設施,其戰略重要性堪比早期的雲端計算或電力。對於長期投資者而言,這支撐著一個清晰的信念:雖然應用層的贏家可能快速變化,模型經濟學仍存在不確定性,但定位良好的AI基礎設施平台提供了持久複合成長的機會,這種需求植根於物理約束、規模經濟和系統級整合,而非任何單一的AI模型、應用或架構週期。